Можно ли верить медицинской информации в ChatGPT, выяснили ученые Израиля

Использование искусственного интеллекта (ИИ), особенно больших языковых моделей вроде ChatGPT, набирает обороты. Вместе с тем остается важный вопрос: насколько можно полагаться на них в понимании сложной медицинской информации? Не навредят ли советы «доктора с искусственным интеллектом»? Ответ на эти вопросы дает новое исследование, проведенное в Израиле и опубликованное в научном журнале Computers In Biology and Medicine.

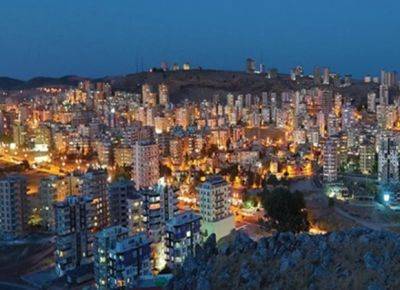

Исследование проводилось учеными университета имени Бен-Гуриона в Беэр-Шеве. Оно проверяло возможность моделей ИИ давать точные ответы на медицинские вопросы. Проверялась способность ChatGPT и его аналогов правильно понимать язык медицины. Результаты удивили ученых.

Сейчас медицинский чатбот отвечает на вопросы пациентов, предсказывая развитие болезней, создает сводные данные о больном и готовит вопросы и ответы для студентов-медиков. Но поскольку модели ИИ в области медицины стали распространенными, возникают вопросы критической важности: может ли ИИ разбираться в тонких различиях между близкими по смыслу медицинскими терминами? Особенно если речь идет о медицинских кодах, которые необходимо точно понимать на высоком уровне. Для проверки ученые сравнили разные

vesty.co.il

vesty.co.il